AI的安全與倫理 狂奔的技術需要“急剎車”嗎?

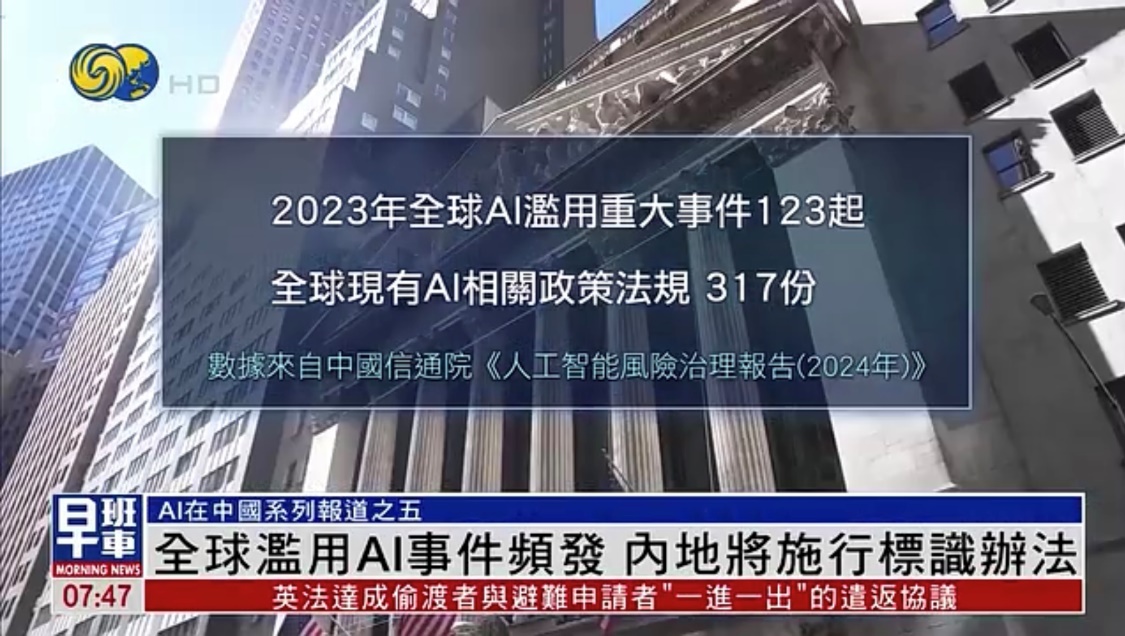

從簡單的答疑,到高效的政務決策,AI已深度融入人類生活。當技術狂奔突進,一場關於安全與倫理的警報正在全球拉響——我們是否過度依賴了一類尚未成熟的“數字大腦”?又會有什麼風險?鳳凰衛視系列報道《AI在中國》,通過深度採訪及數據調查,解讀AI高速發展背後的安全及倫理問題。

普及背後的隱憂

鳳凰衛視記者在北京街頭開展採訪時發現,市民對 AI 的使用已十分普遍。從事美術工作者會借助 AI 優化畫作,職員用其快速查找資料、做動態分析,提升工作效率。

然而,這種便利也伴隨著風險。站在網絡安全公司的角度,數據洩露風險、通用越獄漏洞、以及內部人員惡意操作是AI湧入後的風險。奇安信總體部技術架構師白明陽舉例道:“比如說通過一些提示詞的注入,去發現製造炸彈的一些教程,可以從我們的企業大模型裡邊去弄出來。”通過特定提示詞注入,用戶可能可以從企業大模型中獲取製作炸彈教程等敏感信息,引發公共安全擔憂。

據每日經濟新聞《智能體體檢報告》顯示,錯誤決策和數據洩露成為業內最關注的AI安全合規問題,超 7 成受訪者擔憂這兩類問題;緊隨其後的,就是超過5成人關注的有害內容輸出,以及超過4成人關注的提示詞注入。政企內部大模型被盜用生成有害信息,不僅威脅公共安全,也對其聲譽造成沉重打擊。

倫理爭議與法律困局

但長遠看,過度依賴人工智能大模型,潛在的司法爭議和倫理爭議也應該被高度重視。作為一項常見的應用,AI聊天機器人也引發不少爭議。今年6月外媒報道美國一女子起訴 AI“教唆”其子自殺的案例,國內也曝光部分國產 AI 軟件存在色情擦邊、誘導自殘等問題。

針對這一問題,北京市金台律師事務所高級合伙人閆川接受採訪時分析:“我們人與人之間的交流會考慮到善惡問題,會考慮到基本的道德觀念,但AI沒有,AI只是說它依照自己的程序和算法去給出你用戶想要的答案,包括倫理方面。如果你依賴這個工具的話,他就會比你的思想更往前一點,那麼就會產生這種有可能他會誘導你去做一些可能你並不想做的事情。”

同時,閆律師還發現在AI參與撰寫的材料中,出現了捏造事實或擅自修改法條的情況。他說:“因為法條是很嚴肅的,一個字都不能改,那麼AI有些時候可能會為了達到這個提問者的目的,那麼會有一點曲解,甚至故意地有錯漏。”

今年9月,內地將實施《人工智能生成合成內容標識辦法》和同步實施的配套強制性國家標準,明確發佈生成合成內容的,應當主動聲明並使用服務提供者提供的標識功能進行標識。

不過,有法學學者指出,儘管內地已初步針對生成式人工智能等技術進行立法,但人工智能法律屬性、管理體制、法律責任等基礎性法律問題,仍需要一部具有統領性的人工智能高位階立法予以統一規範。

責任編輯 莫家富

上一记者:香港泉州關係密切 為香港繁榮穩定貢獻力量